「業務で使ってみたいけれど、情報漏洩が怖くて踏み出せない…」

「何をどこまで入力していいのか、線引きがわからず不安。」

「もしトラブルになったらどうしようと考えると、利用を躊躇してしまう。」

ChatGPTの利便性が話題になる中、現場の業務効率化のために活用したいと考えるのは当然です。しかし、専任の担当者がいない中でセキュリティのリスクを正しく把握し、自社に合った運用ルールを一から作るのは容易ではありません。

この記事では、4,000人以上にAI研修を実施してきた弊社がChatGPTに潜む具体的なリスクについてわかりやすく解説します。

この記事を読むことで、入力してよい情報とダメな情報の区別が明確になります。身近な業務から安心して活用の一歩を踏み出せるようになるでしょう。

記事監修者

久保田 亮-株式会社メイカヒット代表

【経歴・実績】

・4,000人以上へのAI研修実績

・Gensparkアンバサダー

・マーケターとしての取引企業200社以上

・マーケティング/広報顧問累計6社

・自社メディアでの販売実績10億円以上

・Webスクールメイカラ主宰

田中 凌平-株式会社メイカヒット代表

【経歴・実績】

・Notta公式アンバサダー

・AIを活用し生産性300%向上

・日本インタビュー協会認定インタビュアー

・年間150名以上の取材実績

・ラグジュアリーブランドで5年勤務

ChatGPTの危険性として指摘されている主なリスク

ChatGPTは便利ですがリスクも伴います。

ChatGPTの主なリスクとして指摘されているものは以下の5つです。

- 情報漏洩

- ハルシネーション

- 著作権侵害

- サイバー犯罪への悪用

- 業務依存・判断力の低下

詳しく説明します。

情報漏洩

ChatGPTにおける情報漏洩の原因は、入力したデータがAIの学習に再利用される仕組みにあります。

ChatGPTはすべての入力情報を学習するわけではありません。利用するプランや形式によって、データの取り扱いは明確に異なるためです。

個人向けのChatGPTでは、デフォルト設定において入力内容がAIの学習データとして活用される可能性があります。一方、API利用や業務向けプランであれば入力データは学習に利用されず、セキュリティ基準が区別されているのです。

情報漏洩の原因はChatGPT自体ではなく、学習利用される環境に業務データを入力してしまうことによって発生します。

ハルシネーション

ChatGPTには、事実とは異なる嘘の情報を生成するハルシネーションというリスクがあります。

ChatGPTは不確実な情報に直面したとき、確率的に自然に見える言葉を推測して補完する仕組みを持っているからです。

実際に誤情報の拡散が報道されています。特に最新情報を扱う場面では、堂々と誤りを述べるケースがあります。

正解のように見えても実は誤りであるというハルシネーションは、情報の正確性を損なうリスクの一つです。

久保田

久保田「堂々と間違える」のがハルシネーションの怖いところです。「AIが言っているから正しいはず」という思い込みは捨て、あくまで優秀な助手として扱うのが正解です!

著作権侵害

ChatGPTの生成物が既存のコンテンツと類似し、著作権侵害となるリスクがあります。

AIが学習した既存のコンテンツと、類似性の高い成果物が出力される可能性があるからです。

新商品のキャッチコピーを考えさせた際に、他社が使用している有名なフレーズや商標と同じものが提案されてしまう場合があります。知らぬ間に既存の作品に似てしまい、訴訟などのトラブルに発展するケースも否定できません。

ChatGPTの生成物は必ず人の目で確認し、既存コンテンツとの類似性がないかをチェックすることが重要です。最終的な責任は利用者側にある点を理解しておく必要があります。

サイバー犯罪への悪用

ChatGPTの技術は、サイバー犯罪や詐欺に悪用される懸念があります。

巧妙なフィッシングメールや偽情報を、専門知識がなくても容易に作成できてしまうからです。

具体的には、以下のような悪用事例が想定されます。

- 本物そっくりの詐欺メール文面

- 実在しない人物の偽画像や動画

- 社会を混乱させるデマ情報の生成

誰でも簡単に使えるというChatGPTの利便性が、裏を返せば犯罪の敷居を下げてしまうという危険な側面を持っています。

業務依存・判断力の低下

ChatGPTへの過度な業務依存は、判断力の低下も招く深刻なリスクの一つです。

ChatGPTに任せきりにすると情報の正誤を見抜く力が養われず、業務に必要な知見も蓄積されないからです。

楽をして結果が得られる反面、自分で考える機会が減り本質的なスキルが育たなくなる可能性も否定できません。

ChatGPTに業務依存しすぎてしまうと人間が本来持っている思考力や判断力を奪ってしまうリスクが潜んでいます。

ChatGPTを安全に使うために今すぐできる対策

ChatGPTを安全に利用するには、情報漏洩や誤情報の拡散リスクへの対策が必要です。

今日から実践できる対策は以下の3つです。

- オプトアウト設定で学習利用を防ぐ

- ファクトチェックを前提に使う

- 個人情報・機密情報を入力しない

詳しく見ていきましょう。

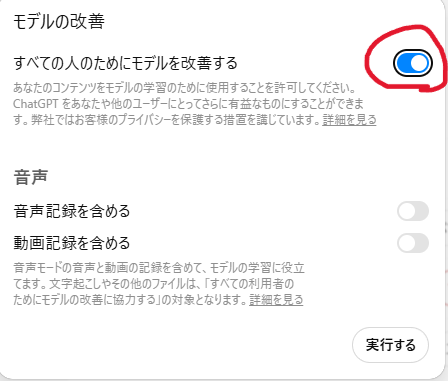

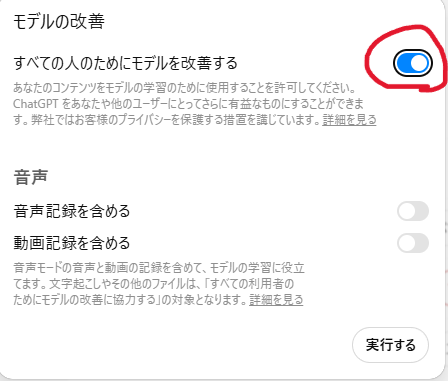

オプトアウト設定で学習利用を防ぐ

オプトアウト設定とは、入力したデータが学習に利用されないように利用者側でコントロールする設定のことです。

初期状態では「学習する」設定になっているため、ChatGPTを安全に利用するために、最初に行いましょう。

オプトアウト設定の運用は文部科学省のガイドラインでも推奨されており、組織で利用する際の重要な基準となっています。

具体的には以下の手順で設定します。

引用元:ChatGPT

情報漏洩を未然に防ぐためにも、オプトアウト設定を済ませてから業務に活用しましょう。

デフォルトで「学習する」設定になっていることがほとんどです。「何も設定していない=情報を渡している」状態なので、必ず手動でオプトアウトを有効にしてください!

ファクトチェックを前提に使う

ChatGPTを利用する際は、回答の事実確認を行うファクトチェックが欠かせません。

ChatGPTは事実と異なる情報を生成する恐れがあり、真偽を確かめずに業務で使うと、誤情報を拡散してしまうからです。

回答を得た際は、以下の内容を意識してファクトチェックしてください。

- 公的機関の一次情報を確認する

- 複数の情報源と照らし合わせる

- 専門家の見解と矛盾がないか調べる

ChatGPTの回答を鵜呑みにせず、事実確認をセットで行うことが安全な活用の鍵になります。

個人情報・機密情報を入力しない

ChatGPT利用時は、個人情報や機密情報をそのまま入力せず、マスキング処理をして入力することが有効です。

機密情報を実名のまま入力すると、保存・共有・学習利用などのリスクを完全には排除できないからです。

以下のように、情報を置き換えて入力することで安全性を高められます。

- 氏名→「Aさん」「担当者X」

- 会社名→「従業員50名の製造業」

- 顧客情報→「30代男性の顧客」

- 金額・日付→「数十万円規模」「202X年」

- メール文面→固有名詞を削除し構成のみ入力

具体情報を保ったまま特定要素だけを匿名化するマスキング入力を行えば、情報漏洩を抑えつつChatGPTを実務で活用できます。

リスクを理解した上でChatGPTを安全に使う方法

ChatGPTを安全に活用するには、個人のリテラシー向上と組織的なルール整備が不可欠です。

ChatGPTを安全に使う方法は以下のとおりです。

- 社員・個人が守るべきポイントを押さえる

- 組織として整備すべき管理体制を整える

- 小さく試して徐々に活用範囲を広げる

ここでは、リスクを理解した上でChatGPTを安全に使う方法について説明します。

社員・個人が守るべきポイントを押さえる

社員や個人が守るべきポイントはChatGPTの回答を鵜呑みにせず、最終的な判断と責任は人間が持つというリテラシーです。

ChatGPTは誤った情報を出力する可能性があり、文部科学省の指針でもあくまで参考の一つとされています。

個人が意識すべきモラルは、以下のとおりです。

- 事実確認(裏取り)を必ず行う

- 著作権や利用規約を遵守する

- AIを「決定者」にせず補助として使う

ChatGPT任せにせず、最後は人間が責任を持つというモラルが、安全に使う方法になります。

組織として整備すべき管理体制を整える

組織として整備すべき体制は、リスク管理や運用ルールを明確に決めることです。

社員個人の判断に任せると、思わぬトラブルに対応できなくなってしまうからです。

デジタル庁のガイドラインでも、組織全体での管理や、効果的な使い方の共有が必要だとされています。具体的には、使っていい業務の範囲を決めたり、トラブル時の報告手順を作ったりする必要があります。

事前に体制を整えてルールが明確になれば、社員も迷わず業務に利用ができ、安全に活用できる土台となるでしょう。

小さく試して徐々に活用範囲を広げる

リスクを抑えるためには、小さく試して徐々に活用範囲を広げる段階的な導入が有効です。

万が一ChatGPTが間違えても問題が起きない作業でテストし、安全を確認してから本格的に使うほうが確実だからです。

例えば、公開されている情報の要約や下書き作成など影響の少ない業務から始め、徐々に使う場所を増やしていくのが基本になります。

問題がないか確認したうえで、少しずつ活用範囲を広げていくと、トラブルを防ぎながら安心して業務に取り入れられます。

ChatGPTの危険性を回避する【安全利用チェックリスト】

ChatGPTは正しく使えば便利なツールですが、設定や使い方を誤ると情報漏洩や誤情報のリスクがあります。

以下のチェックリストを使って、安全に利用できているかを確認しましょう。

利用前に確認すること

- 学習利用を防ぐ設定(オプトアウト)を確認している

- 利用目的が情報収集・下書きなど低リスク用途である

- 入力禁止情報のルールが明確になっている(社外秘・顧客情報など)

利用中に気をつけること

- 回答内容を鵜呑みにせず、必ず事実確認している

- 専門的・最終的な判断は人が行っている

- 著作権のある文章をそのまま使用していない

- 個人情報や機密情報を入力していない

業務利用・継続利用時の確認

- 社内ルールやガイドラインを確認している

- 出力結果の共有・保存範囲を把握している

- 定期的に設定や利用方法を見直している

ChatGPTの危険性に関するよくある質問

まとめ|ChatGPTは危険ではない、正しいルールで安全に活用しよう!

ChatGPTは、業務効率化や生産性向上を実現するために欠かせない強力なツールです。

どのようなリスクがあるのかを正しく理解しなければ、予期せぬトラブルを引き起こし、企業の信用を損なう事態になりかねません。

リスクを知れば、対策は可能です。ツールを利用するだけでなく、組織全体で安全に使いこなすルールを作ることが本当のゴールです。

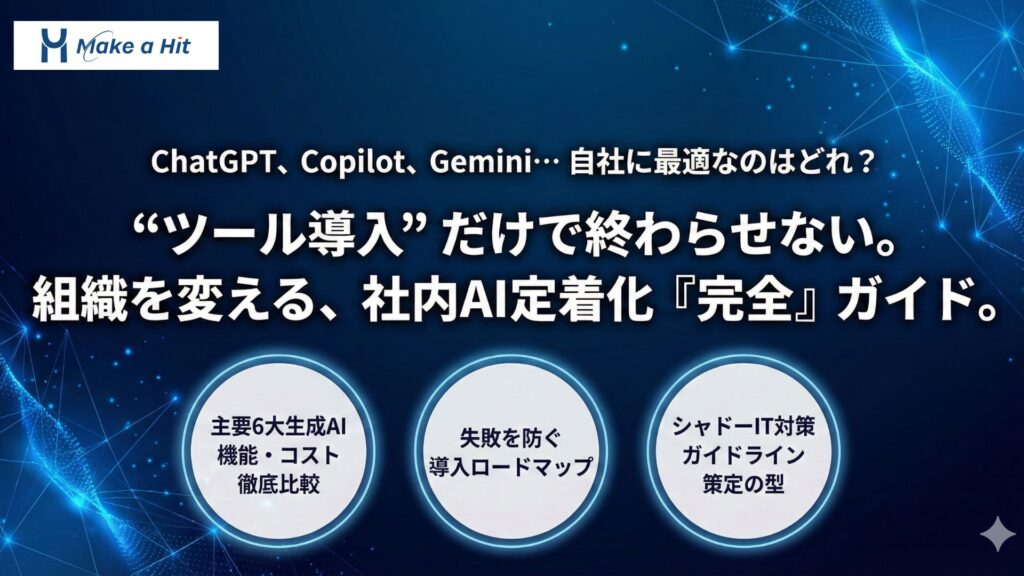

「セキュリティやガイドラインを自分たちだけで策定できるか不安」

「社員のリテラシーにばらつきがあり、安全に運用できる自信がない」

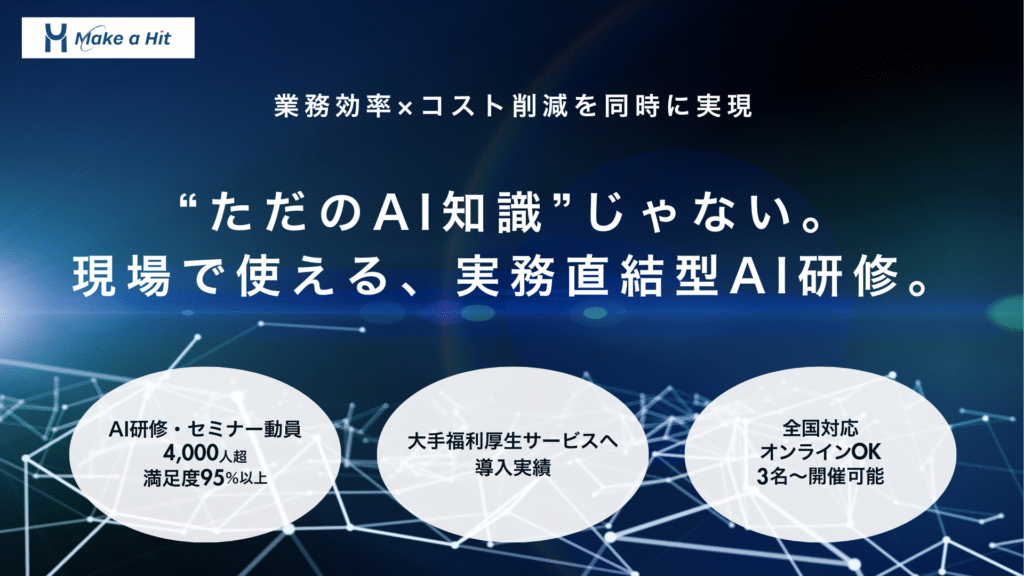

そんな悩みを解決できるのが、メイカヒットのAI研修です!

実務に即したカリキュラムで、社員のセキュリティ意識を統一・底上げし、リスクを抑えながらAIを活用できる体制を整えます。

- ChatGPTの正しい使い方とリスク対策を習得させたい

- 情報漏洩を防ぐ具体的な社内ルールを作りたい

- 現場の業務に合わせた安全な活用事例を知りたい

- トラブル時の対応フローが定まっていない

- 専任の担当者がおらず、セキュリティ教育が進まない

- 社員の不安を取り除き、DXを加速させたい

現場の課題やセキュリティ基準に合わせて内容をカスタマイズできるため、実務に直結する安全な運用力が身につきます。

メイカヒットのAI研修では、現場のルール策定&定着支援付きだから、セキュリティに不安がある企業様でも安心して導入を進められます!

リスクを正しく管理し、安全に成果を出す組織を作るためには、適切な研修が不可欠です。

メイカヒットのAI研修では、4,000人以上への実績をもとに、リスク対策を含めた最適なプログラムを提供しています。

ルールの策定から現場への浸透まで、貴社のChatGPT活用を確実に成功させるサポートを行っています。

過度な恐れを捨てて第一歩を踏み出し、安心してAIを活用できる組織を作り上げましょう!